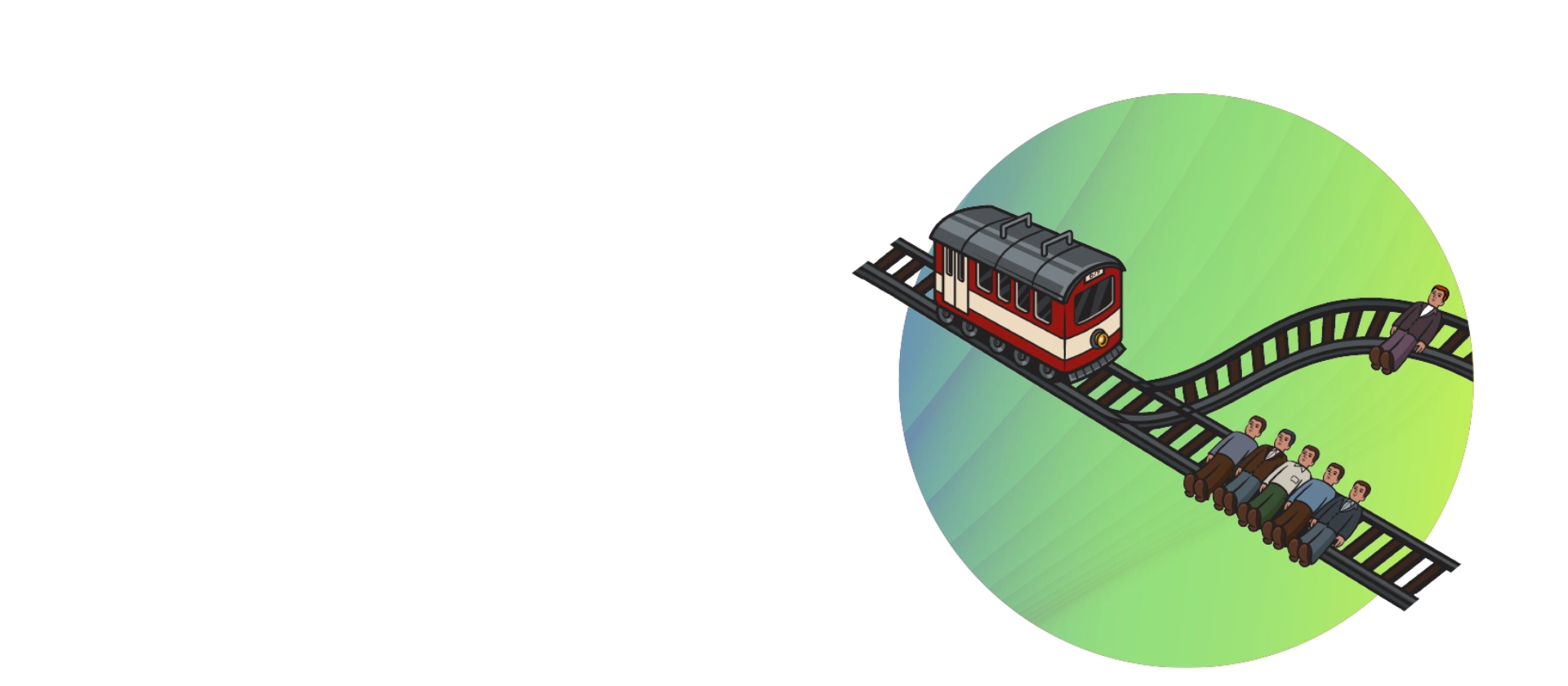

Stellen Sie sich die Straßen von San Francisco vor. Eine außer Kontrolle geratene Tram rast einen Hang hinunter. Etwas weiter unten teilt eine Weiche die Fahrspuren. Geradeaus liegen fünf Personen hilflos gefesselt auf den Schienen. Auf dem Abzweig nach links liegt eine einzelne Person, ebenfalls hilflos gefesselt, auf den Schienen.

Zufällig stehen Sie an der Weiche und können – müssen – entscheiden und mittels des Stellhebels Schicksal spielen. Entscheiden Sie sich für das Ziehen des Hebels, wird die Tram umgelenkt und überfährt nur eine Person. Entscheiden Sie sich gegen das Ziehen, sterben fünf Personen. Wie ist Ihre Entscheidung?

Das moralisch-ethische Dilemma

Dieses moralphilosophische Experiment stammt ursprünglich aus dem Jahr 1930,1 lange bevor wir angefangen haben zu diskutieren, wie wir ein KI-gesteuertes, autonom fahrendes Fahrzeug so programmieren

können, dass es in jeder Gefahrensituation „moralisch richtig entscheidet“ und Leib und Leben möglichst aller Verkehrsteilnehmer schont.

Ernsthaft bemühte Ansätze, diese Fragestellung für unsere künstlich belebten Helfer universell zu lösen, wie zum Beispiel Isaac Asimovs Robotergesetze 2 (schon) aus dem Jahr 1942 oder Stuart Russels „Three principles for creating safer AI“ 3 von 2017 stoßen in einer fiktiven „gelebten Praxis“ schnell an ihre Grenzen. Wie entscheiden, wenn es sich bei den fünf Personen auf dem einen Gleis um fünf alte Männer handelt und bei der einen Person auf dem anderen Gleis um eine Frau? Wie, wenn die fünf verurteilte Straftäter sind und die eine ein Nobelpreisträger? Oder aber ein ehemaliger Nobelpreisträger mit Demenz, der in den nächsten drei Monaten an Krebs sterben wird? Oder „einfacher“: wenn die fünf ungeliebte Verwandte sind und der eine ein Kind? Und wie, zur Hölle, soll eine KI das wissen?!

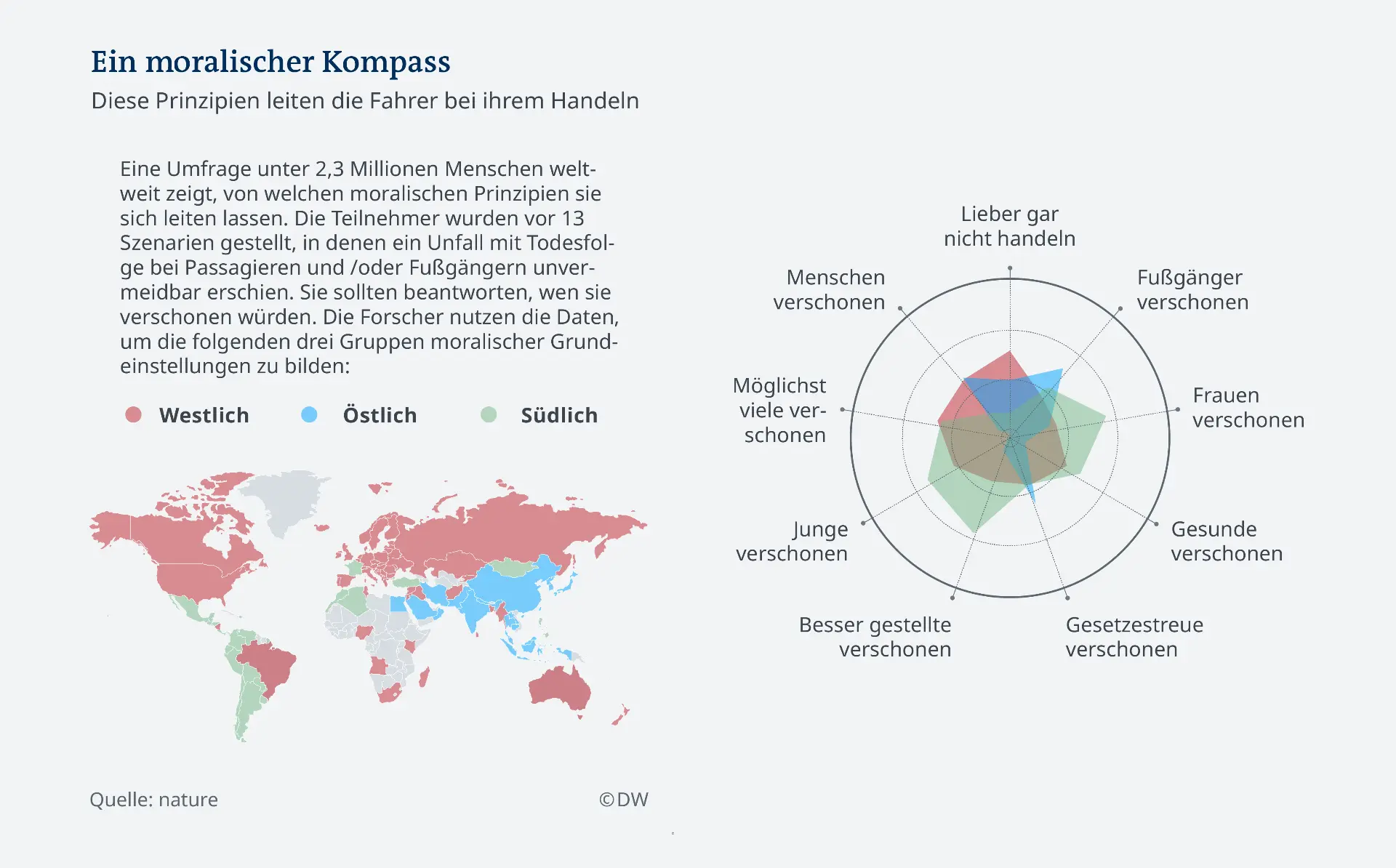

Man hat dieses Gedankenexperiment in einem weltweiten Versuch millionenfach durchgeführt (siehe Abbildung 1) – mit einem klaren, unbarmherzigen Ergebnis: Moralische Entscheidungen sind nicht universell.4 Welches Leben mehr „wert“ ist, hängt vom jeweiligen Kulturkreis ab.

Was also würde passieren, wenn ein in Asien entwickeltes autonomes Fahrzeug sich auf unvermeidlichem Kollisionskurs mit einem in Europa entwickelten autonomen Fahrzeug befindet? Ausgang ungewiss.

Aber warum sind die Antworten auf diese moralischen Fragen nicht universell gültig und damit auch automatisierbar? Selbst wenn wir davon ausgehen, dass alle Kontextinformationen im Augenblick der Entscheidung verfügbar sein werden – zwar noch nicht jetzt, aber angesichts unseres Umgangs mit Daten und Privatsphäre in absehbarer Zukunft –, ändert das nichts am ethisch-moralischen Kern des Entscheidungsproblems, denn dieser Kern ist nicht statistisch oder algorithmisch erfassbar, errechenbar, sondern zutiefst menschlich.

Sich an einem christlich-demokratisch geprägten Gesellschaftsbild zu orientieren, wie es in der Politik und in der Öffentlichkeit hierzulande immer wieder propagiert wird, greift schon deswegen zu kurz, weil weltweit nur 24 Staaten vollständig demokratisch regiert werden5 und nur rund 31 Prozent der Weltbevölkerung christlich geprägt sind.6