Wir bringen KI zum Laufen

Von MLOps über LLMOps und AgentOps zu KI-Plattformen

Wir bringen KI zum Laufen: Von MLOps über LLMOps und AgentOps zu KI-Plattformen

Der Weg von einem vielversprechenden Machine-Learning-Modell hin zu einer stabil laufenden, skalierbaren KI-Lösung ist komplex. Daten ändern sich, Modelle veralten, neue Anforderungen entstehen. Und gleichzeitig steigen Erwartungen an Geschwindigkeit, Nachvollziehbarkeit und Sicherheit.

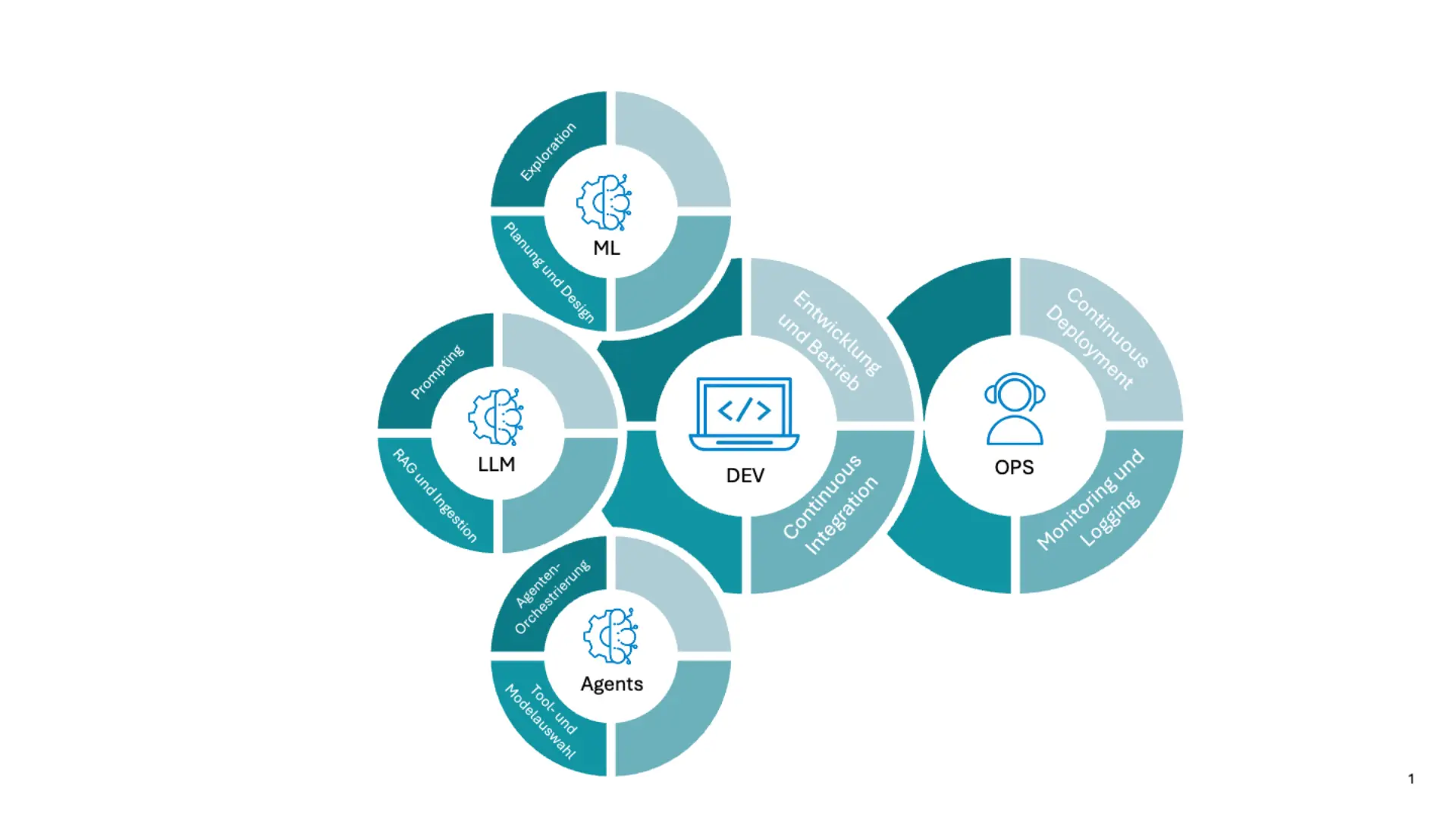

MLOps, LLMOps und AgentOps schaffen die Grundlage für reproduzierbare Entwicklung, kontrolliertes Deployment und kontinuierliches Modell-Lifecycle-Management.

Wir entwickeln Betriebsmodelle, Plattformen und Prozesse, die KI ganzheitlich unterstützen. Von der Exploration über das Deployment bis hin zur Überwachung im Produktivbetrieb. So werden ML-Modelle, LLM-Lösungen und Agenten-Systeme zuverlässig, sicher und wirtschaftlich betreibbar.

Ihr Ansprechpartner

„KI ohne MLOps, LLMOps und AgentOps ist wie ein Formel-1-Wagen ohne Boxencrew: Beeindruckend auf dem Papier, aber nicht fahrtauglich in der Realität.“

Von Exploration bis Betrieb: So entsteht produktionsreife und zuverlässige KI

Dimensionen für skalierbare KI-Systeme

Am Anfang steht die strukturierte Analyse des Use Cases: Welche Daten liegen vor? Welche KPIs sollen erreicht werden? Welche Risiken bestehen? In dieser Phase sorgen wir für Klarheit über technischen Nutzen, Machbarkeit und Wirtschaftlichkeit.

Wir prüfen Modell- und Architekturvarianten, definieren Erfolgskriterien und legen die Grundlagen für spätere Betriebsmodelle. Dadurch wird schon früh verhindert, dass sich PoCs in Sackgassen entwickeln oder nicht produktionsfähig sind.

Ein stabiles MLOps-Ökosystem braucht klare Rollen und Zuständigkeiten. Gemeinsam definieren wir Aufgaben wie Model Owner, Data Steward, Engineering-Rollen, Standards für Deployment sowie Governance-Mechanismen.

Durch eine konsistente Prozesslandschaft (von Entwicklung über Review bis Freigabe) schaffen wir Transparenz und Sicherheit. So stellen wir sicher, dass Modelle nicht nur technisch funktionieren, sondern organisationell verankert sind und auditierbar bleiben.

In der Entwicklungsphase entstehen Modelle, Pipelines und Feature-Stores. Wir setzen auf reproduzierbare Workflows, Versionskontrolle, strukturierte Testverfahren und Metadaten-Tracking. Damit Experimente nachvollziehbar bleiben und Modelle effizient wiederverwendet werden können.

Wir integrieren moderne Frameworks und sorgen dafür, dass Modelle konsistent gebaut, dokumentiert und bewertet werden. Berechenbarkeit ersetzt Zufall.

Continuous Integration stellt sicher, dass Code, Datenpipelines, Features, Tests und Modelle als Einheit funktionieren. Wir etablieren Standards für automatisierte Tests (Datenqualität, Modellverhalten, Contracts) und sorgen dafür, dass jede Änderung sicher geprüft wird.

Ziel ist ein vorhersehbares, verlässliches Entwicklungsökosystem bei dem Qualität kein Zufallsprodukt ist.

Moderne KI braucht einen stabilen Auslieferungsprozess: Versionierung, Rollback-Mechanismen, Canary-Deployments, Freigabeprozesse und sichere Modellregistrierung.

Wir entwickeln Deployment-Pipelines, die ML-Modelle, LLM-Anwendungen oder Agenten sicher in produktive Systeme integrieren, On-Premise, Cloud oder Edge. Durch Automatisierung reduzieren wir Risiko, Kosten und Zeit bis zur produktiven Nutzung.

Nach dem Deployment beginnt ein wichtiger Teil: das Monitoring. Wir überwachen Modellqualität, Datenveränderungen, Performance, Ausfälle, Latenzen, Kosten, Bias und Explainability-Signale.

Durch Drift-Erkennung und automatisierte Retraining-Pipelines bleiben Modelle stabil und anpassungsfähig. Operational Excellence bedeutet: KI verhält sich auch im laufenden Betrieb zuverlässig, nachvollziehbar und kontrolliert.

Agenten und LLM-basierte Systeme benötigen eigene Betriebsmodelle. Neben klassischen ML-Artefakten müssen auch Rollen, Regeln, Tools, Prompt-Profile, Koordinationslogiken sowie Aktionsabläufe versioniert und überwacht werden.

Wir etablieren dedizierte AgentOps-Prozesse: Simulationstests, Action-Protokolle, Tool-Usage-Monitoring, Kostenüberwachung, Halluzinations-Erkennung und Validierungsmechanismen.

So wird die Handlungsfähigkeit der Agenten mit Sicherheit, Governance und Auditierbarkeit verbunden.

Eine leistungsfähige KI benötigt eine Plattform, die Daten, Modelle, Werkzeuge, Sicherheitsmechanismen und Betriebsprozesse verbindet: Ein echtes KI-Ökosystem. Wir entwickeln Plattformarchitekturen auf Basis von Hyperscaler-Plattformen, Open-Source-Technologien oder hybriden Ansätzen, die durchgängige End-to-End-Prozesse ermöglichen.

Diese Systeme bilden den zentralen Ort, an dem Modelle entwickelt, überwacht und bereitgestellt werden. Sie ermöglichen Wiederverwendung, Standardisierung und langfristige Skalierbarkeit.

Wie können Plattformen und Ökosysteme beim Aufbau von KI-Use Cases unterstützen:

Unser Leistungsangebot

- Aufbau von MLOps-, LLMOps- und AgentOps-Prozessen

- Entwicklung reproduzierbarer ML- und LLM-Pipelines

- Aufbau von CI/CD für Modelle, Pipelines, LLM-Workflows und Agenten

- Integration von Model Registry, Feature Stores, Monitoring & Observability

- Architektur & Implementierung von KI-Plattformen (Azure, Databricks, Kubernetes)

- Governance, Rollenmodelle & Betriebsmodelle für KI-Organisationen

Ergebnisse & Mehrwert

- Schneller, sicherer und kontrollierter Rollout von KI-Lösungen

- Deutlich geringere Kosten durch Automatisierung

- Lebenszyklus-Management für Modelle, LLMs und Agenten

- Höhere Qualität und Stabilität im Produktivbetrieb

- Zukunftssichere KI-Ökosysteme, die mitwachsen